In der SEO (Suchmaschinenoptimierung) geht es darum, bei eben diesen Suchmaschinen besser gefunden zu werden. Klicks zu generieren, die frei von Kosten sind und bleiben. Webmaster beschäftigen sich mit SEO und machen ihre Webseiten besser. Besser für Google, besser für Nutzer, gut so. Und trotzdem schleichen sich immer wieder kleine, fiese SEO-Fehler ein. Hier kommt die Top 10 der SEO-Fehler, auf die ich immer wieder gestoßen bin, die so vermeidbar sind.

Inhalt des Artikels

10 gravierende SEO-Fehler die du vermeiden solltest

Gerade zu Beginn einer SEO-Karriere macht ein Jeder noch diverse SEO-Fehler. Manche sieht man nicht selbst, bei manchen ist man nicht ehrlich zu sich selbst und manchmal ist man einfach nur Betriebsblind.

Sobald du versucht besser gefunden zu werden, noch mehr SEO zu lernen und anzuwenden, vergisst du schnell zu analysieren oder zu verstehen. Du liest einen SEO-Blog nach dem anderen, immer den neuesten Stoff. Du liest neues und brütest über diversen SEO-Tutorials. Doch es geht einfach nicht mehr voran im Ranking. Die Seite wird nicht besser oder es lief noch nie? Das könnte an einem dieser SEO-Fehler liegen.

Meist sind sie unscheinbar, unbeabsichtigt und nützlich wie ein Absprung nach 0,5 Sekunden.

1. Fehler bei der Indexierung & Deindexierung

Der meiner Meinung nach häufigste SEO-Fehler ist trivial und banal, aber doch zerstört er jede Chance auf gute Rankings. Es ist genau der Fehler, der zu 95 % der Grund dafür ist, dass eine Webseite gar nicht bei Google gefunden wird.

Die meisten denken dann sofort an ein Google-Update, eine Strafe durch den Giganten in der Branche. Und doch ist es meist so, dass der Googlebot deine Seite crawlen darf, aber nicht indexieren. Das kleine Böse Meta-Tag-Robots, dass auf NoIndex gestellt ist. Es ist häufig der Grund für absolutes und permanentes Fehlen im Google-Index.

Doch es geht auch anders rum. Du kennst dieses Duplicate-Content-Problem und löst es, durch Deindexierung des doppelten Inhaltes. Das kann man schon so angehen, aber wie?

Mit der robots.txt das Crawlen des doppelten Inhaltes verbieten und schon ist der doppelte Inhalt aus dem Index verschwunden? Nope, der bleibt beharrlich stehen. Zusätzlich noch ein Noindex ins Meta-Tag-Robots? Fast!

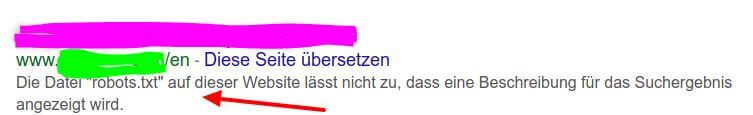

Aufgrund der des Crawlverbots in der robots.txt kann ein Bot dein Meta-Tag-Robots leider gar nicht sehen. Er kann also die Seiten nicht deindexieren und sie verbleiben im Index. Jetzt aber auch mit dem Hinweis des Crawlverbots von dir. Schonmal gesehen, oder?

Eine Seite die indexiert wurde, trotz Crawlverbots (Disallow) in der robots.txt. Sie sieht im Google-SERP so aus.

SEO-Fehler bei der Indexierung und Deindexierung passieren öfter als andere Fehler. Daher folgende wichtige Punkte:

- De- oder Nicht-Indexierung kann nur mit dem Meta-Tag-Robots passieren, nie mit der robots.txt

- Wenn eine gute Seite gar keinen organischen Traffic bekommt, dann ist sie vermutlich nicht indexiert.

2. Blockierte Ressourcen

Google möchte deine Seite gern indexieren und ranken, wenn sie denn gut ist. Um das einschätzen zu können, da muss der Googlebot deine Seite rendern. Er möchte also sehen, was der Nutzer zu sehen bekommt.

Das alles passiert nur dann, wenn du dem Bot auch erlaubst, alle Ressourcen zu crawlen, die deine Webseite verwendet. Jedes Bild, jedes Script, jedes CSS. Viele Webseiten blockieren einige dieser Ressourcen. Sei es ein Ordner mit statischen Bildern oder ein WordPress-Plugin zum Beispiel, dass auf Bilder, Styles oder Scripte im „WP-includes“ Ordner zugreift. Dieser Ordner ist in der Regel für Bots verboten. Ein SEO-Fehler der häufig durch Unachtsamkeit oder Unwissen passiert.

Die Google-Search-Console warnt Webmaster und SEO’s vor diesem Fehler, also nutze die Search Console! Auch das SEO-Tool Screaming-Frog kann dir diese intern blockierten Ressourcen zeigen. Blockierte Ressourcen führen zu schlechteren Rankings – umgehend. Heb die Blockierung auf, dafür genügt meist eine Zeile in der robots.txt. Manchmal nur ein Zeichen!

Jede für das Rendering verwendete Ressource (Bild, Style, Script, etc.) muss ein Bot crawlen können! Wenn du nicht weißt wie der Bot deine Seite sieht, da kann dir diese Anleitung zum Rendern wie Google helfen.

3. Grill an! Jetzt werden Keywords kannibalisiert

Der Trend zum Kannibalismus ist bei SEOs weit verbreitet. Ein Keyword muss scheinbar so gut durch sein, dass weder User noch Bots wissen, wo die Antwort steht und wo dieser „für die Maschine“ geschriebene Kram.

Vermutlich liegt es an einer Keyworddichte (welche selbst schon ein SEO-Fehler ist) oder dem falschen Verständnis für Keywords und Themen. Die Keyword-Kannibalisierung ist ein immer wieder auftauchender SEO-Fehler.

Bei diesem Fehler gibt es kurz gesagt mehrere Seiten, die auf das gleiche Keyword optimiert sind. Google weiß dann nicht, welche die relevante fürs Ranking ist. Außerdem machst du dir selbst Konkurrenz und teilst deine Rankingchancen durch X.

Manchmal ist das technisch ein Problem, sei es durch fehlende Paginierung, falsche Canonicals oder einfach ein falsch eingerichtetes Filtersystem in einem Online-Shop.

Doch meistens passiert der Fehler entweder absichtlich oder aus Unsicherheit was genau aus der Keyword-Recherche auch einen eigenen Inhalt verdient hat.

Absicht würde bedeuten, du optimierst mehrere Seiten auf das gleiche Wort, um möglichst viel zum Thema zu sagen. Wenn du so vorgehst, bitte drück deine Reset-Taste, versuch SEO mal aus anderen Quellen zu lernen.

Wenn die Kannibalisierung aus Unsicherheit bei der Keyword-Recherche herrührt, dann weil du vielleicht zu klein gedacht hast. Oder weil dir nicht klar ist, ab wann genau eine extra Seite für bestimmte Keywords notwendig ist.

Das Schwierige bei der Keyword-Recherche ist nämlich nicht das Finden von Suchvolumen, Keywords, Longtails und Chancen. Sondern herauszufiltern, was alles auf eine Seite kommt, was ein Extra-Beitrag ist und was der User erwartet (User-Intent).

Auf ein und dasselbe Keyword sollten nie mehrere Seiten optimiert werden!

4. Optimierung für Maschinen

Davon sind wir doch alle schon völlig frei! Optimieren für Maschinen ist ein SEO-Fehler, den niemand mehr begeht. Aber lies ruhig weiter, vielleicht entlarve ich dich!

Erstmal sei gesagt, wenn etwas nur für den Bot gemacht wird, ohne damit an den Menschen, den Leser gedacht zu haben, dann kann das keine Rankings bekommen. Das geht einfach nach hinten los und kein Google, nicht mal Bing hat dann noch eine Rose für dich.

Optimize for human beings not for the machines

Doch bevor du denkst, du bist befreit davon, stelle ich ein paar Fragen: Hast du in letzter Zeit

- ein Keyword oder ein Synonym in deinen Text oder eine Überschrift gepackt, weil es noch nicht (oft genug) erwähnt wurde?

- eine weitere Überschrift eingebaut, denn es waren zu wenige?

- ein Wort einfach dazugemogelt, dass laut WDFxIDF-Analyse nicht fehlen sollte?

- eine unatürliche Phrase eingebaut, um ein Exact-Match-Keyword erwähnen zu können?

- ein Bild eingebaut, nur um ein Alt-Attribut zu haben?

- einen Artikel verlinkt, weil du denkst das hilft dir hier?

- Backlinks erstellt, erfragt nur um einen Link zu haben. Denn alle anderen haben mehr davon?

- Content erstellt ohne genaue Recherche der Keywords und ohne diese Keywords selbst zu googeln?

- einen Absatz ergänzt, um eine Anzahl an Worten zu erfüllen?

- schnell mal etwas Content erstellt, um mehr Content zu haben?

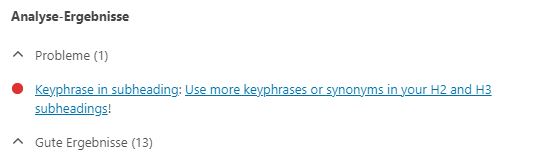

- etwas an einem Artikel gebastelt, bis das Yoast-SEO-Plugin endlich gesagt hat, deine SEO ist jetzt grün und Ok?

Kleinigkeiten können sich schnell mal multiplizieren. Wer schon lange dabei ist, der ist geneigt die schnelle Lösung zu suchen. Solche Vorgehensweisen musst du dir abgewöhnen, denn jedes Core-Update quittiert dir das.

Der Mensch und seine Erwartung an das Suchergebnis ist dein wichtigster Faktor.

5. Den Kampf ansagen, den du nicht gewinnen kannst

Hierbei geht es mir um Old-School-Maßnahmen und Fehler durch Abgucken. Google und seinen Algorithmen und Updates den Kampf ansagen – ob gewollt oder ungewollt.

Seit es die Suchmaschinen gibt, gibt es Betrugsversuche. Texte verstecken, Keywords spammen, billige Backlinks aufbauen. Glaube mir Google kennt auch wirklich jede Idee, deine ist nicht neu.

Eine Suchmaschine bei der an sehr vielen Ergebnissen (ein Drittel aller Ergebnisse) eine künstliche Intelligenz beteiligt ist, die lässt sich nicht so leicht betrügen. Jeder Betrugsversuch ist ein SEO-Fehler.

Doch warum solltest du das tun? Vielleicht weil du denkst: Bei dem funktioniert es doch auch! Egal was du glaubst, was ein anderer tut, es heißt nicht, das er deswegen rankt.

Wenn ein Konkurrent irgendwo einen scheinbar spammigen Text auf seiner Seite hat, dann solltest du ihn nicht nachahmen. Es ist so, dass er trotz des Spams rankt und nicht wegen dem Spam!

Wenn ein weiterer Konkurrent ein Dutzend Follow-Backlinks aus Branchenbüchern, Webkatalogen, Foren, Blogkommentaren oder Bookmarkdiensten hat, ist das genauso. Du kannst gar nicht wissen, welche dieser Links er wirklich hat und welche er per Disavow-Tool hat ausschließen lassen.

Spiel nicht mit Google Guidelines und tue nichts, nur weil ein Konkurrent das tut!

6. Es war einmal der Inhalt, der Mehrwert und Überoptimierung

Ein guter SEO-Text liest sich wie ein Märchen, denn der Content is King und die Queen ist der Mehrwert. Haben alle verstanden wie das Spiel zwischen Unique-Content und Queen-Value läuft?

Kurz gesagt: Unique-Content (einzigartiger Inhalt) ist für jeden von uns leicht zu erreichen. Eine Hürde, die auch der Müde Klepper nimmt. Das reicht nicht für ein Ranking, ist aber nötig für Indexierung. Der König Content ist ein Muss, um gefunden werden zu können, jedoch kein Bonus und keine Garantie.

Die Queen „Unique-Value“ ist der Faktor, der dich im Ranking voranbringt. Es ist dein einzigartiger Mehrwert, der dir das Tor zu Googles Seite 1 eröffnet.

Diese Geschichte haben viele nicht zu Ende gelesen. Immer wieder kannst du es lesen: „Ich habe überall Unique-Content, 2000 Wörter und ich werde nicht gefunden!„. Der SEO-Fehler hier ist, der Glaube daran, dass etwas einzigartiger Inhalt genügt, um gefunden zu werden.

Ich könnte jede Seite von Wikipedia in andere Worte fassen, die im Original auf Position 1 bei Google steht. Aber damit komme ich nicht auf Platz 2. Ich komme nicht mal auf Seite 1, egal wie unique ich mich ausdrücke. Und wenn du bis hierher gelesen hast, für „unique ausdrücken“ hab ich hin und wieder Talent durchgucken lassen.

Fehlender Mehrwert wird dann oft durch einen zweiten SEO-Fehler kompensiert: Überoptimierung. Gerade wenn du mit deinem Content auf Position 11, 12, 13 stehst, dann holst du dir das letzte bisschen! Hier noch ein Bild, schön mit SRC- und Alt-Keywords. Vielleicht hier noch die Überschrift mehr exakt, den Title etwas pimpen. Immer noch nicht Seite 1! Dann hier noch ein Keyword und da ein Linktitle, funktionieren eigentlich Bild-Title? Vielleicht einen schnellen Backlink noch. Und Boom! Seite 3.

- Unique-Content ist ein Muss

- Unique-Value viel mehr

- An die Grenzen gehen ist gefährlich

7. Wie war noch gleich der Weg zum Inhalt

Du sagst sicher auch, dass Google nur eine Maschine ist. Es ist wirklich so, das ist nicht Yahoo von 1997, das ist Google. Sie ist clever genug um sich nicht einfach betrügen zu lassen, aber doch mag sie etwas besonders:

- Klare Signale

- Struktur

- Einfachheit

- Einheitlichkeit

Das gilt an jeder Stelle, im Content und besonders bei Links. Gerade Links mag die Maschine gern, also braucht sie hier eindeutige und klare Signale. Deine interne Linkstruktur sollte sich jedem erschließen. Dein wichtiger Inhalt ist prominent Verlinkt, der unwichtige weniger. Die Klicktiefe der wichtigen Seiten ist niedrig, der unwichtigen hoch. Nofollow verwendest du intern nicht und Ankertexte sind Eindeutig.

Stimmt deine Webseitenstruktur, dann ist das die eine Seite. Glänzt der Content mit gleicher Struktur – perfekt. Lange Vorbereitung für die nächsten Fehler bei der Suchmaschinenoptimierung.

Unklare Signale, schlechte und undurchdachte Strukturen und viel zu wenige interne Links sind so häufig, dass die ersten Arbeitswochen von SEO-Agenturen nur das angreifen. Die „Quick Wins“ – Hauptsächlich Meta-Title und interne Links, sowie deren klare und übereinstimmenden Signale. Schnell sind dann interne Weiterleitungen und ähnliches auf dem Programm.

Verlinke wichtige Seiten häufig und achte auf die Klicktiefe. Achte auf Response Code 200 und das Canonicals nicht auf andere Seiten zeigen. Der Content ist ebenso einfach strukturiert und passt mit Ankern überein.

8. Mixed-Content, SSL, HSTS und wie weiterleiten

Sicherheit ist ein Rankingfaktor und SSL mittlerweile (auch wegen den DSGVO Richtlinien für Webseiten) unumgänglich. Auch dann, wenn SSL als Rankingfaktor nur ein kleiner ist. Manchmal ist nach der Umstellung auf SSL beim Hoster für viele Webmaster Schluss. Aber der Klick beim Hoster war erst der Anfang.

Um wirklich sicher zu sein, solltet eine Website nur über HTTPS kommunizieren können und daher HSTS verwenden.

Außerdem solltest du alles auf HTTPS weiterleiten und dann auch noch alle internen Links auf HTTPS umstellen. Nicht nur im Menü, auch in Beiträgen, CSS, im Template. Jede übriggebliebene Weiterleitung macht die Seite langsam und der Bot crawlt unnötig.

Weiterleiten übrigens permanent, das heißt 301-Weiterleitung, denn nur so kann die Seite auch in den Cache von Mutter Google. Hast du überhaupt vor HTTPS jemals abzuschalten? Wohl nicht, also permanente Weiterleitung 301 für HTTP zu HTTPS verwenden. Ein häufiger SEO-Fehler ist hier die Verwendung von 302.

Außerdem wird HSTS außer Acht gelassen. Das ist eine ganze Zeile in der .htaccess Datei. (Dann ist der Response Code und die Weiterleitung übrigens 307 – mehr dazu hier). Und ganz oft werden die Seiten intern nicht korrigiert. Bei jedem Klick muss der User auf die Weiterleitung warten.

- Verwende SSL und auch HSTS aktivieren

- Intern nur noch HTTPS verwenden

- Permanent Weiterleiten

9. Ich liebe es, wenn ein Plan funktioniert

Einer der größten SEO-Fehler überhaupt ist Planlosigkeit. Da wird eine Maßnahme nach der anderen abgefackelt, aber es fehlt jede SEO-Strategie. Keine Ziele, keine Zeiten, nur Maßnahmen. Das funktioniert dann schon irgendwie, aber eben nicht planbar, zielorientiert oder irgendwie sinnvoll.

Ohne eine Strategie mit Zielen, Zeiträumen und Priorisierung von Maßnahmen, geht jede Kontrolle verloren. Ich garantiere dir, ohne einen Plan weißt du nächsten Monat nicht, was der Ursprung des plötzlichen Ranking-Verlustes oder Ranking-Gewinns ist. Also überwache doch auch, was du tust und ob Erfolg eintritt.

Macht dir einen Plan – erstelle eine SEO-Strategie mit Zielen und Zeiten! Messe Erfolge, lerne aus Misserfolgen!

10. Platz 1 bei Google

Das ist mein Lieblingsfehler. Unter Punkt 10 steht Platz 1 bei Google, allein die Kombo ist ein Kracher – aber worum es geht ist: Platz 1 bei Google zu Keyword XYZ ist nicht dein Ziel! Andernfalls tappst du in meinen Lieblingsfehler.

Viele Webmaster und SEOs zielen auf diesen einen Platz ganz oben. Zu diesem einen Suchbegriff mit dem großen Volumen. Nein, jetzt kommt nicht „kleine Brötchen“. Ehrlich volle Granate auf die großen Fische. Es geht mir um diese unbedingte 1.

Ein besseres Ziel wäre es, wenn du versuchst mit deiner Seite so viele Rankings auf Seite 1 zu bekommen wie möglich. Nicht auf ein Keyword und eine Position fixieren. Wenn alles läuft, du das beste Ergebnis bist, dann erledigen das die User-Signale für dich ohnehin.

Es hat mehrere Gründe:

- Du hast schon Traffic, User-Signale helfen auf Dauer von allein.

- Du hast noch andere Ziele, die mehr bringen. Die helfen vielleicht ebenso.

- Position 1 ist so 90er – die ist weder stabil, noch überall gleich. Dann geh lieber auf die Jagd nach Featured-Snippets.

- Während du eine Position erkämpfst, hat deine Konkurrenz 5 neue Seiten mit 50 neuen Rankings (oder mehr).

Sei nicht so fokussiert auf diese eine Position.

Lasst SEO-Fehler hinter euch

Beginne mit einer Strategie, einem Plan und sei nie fertig mit lernen. Besonders aus Fehlern kann man lernen, das ist auch in der SEO so.

Überwache deine KPIs und Maßnahmen. Kopiere nicht nur, auch nicht die Konkurrenten. Mach deine Webseite und das Internet besser! Verwende SEO-Tools mit bedacht und nimm nicht jeden Hinweis unverstanden hin.

Vielleicht denkst du über SEO-Fehler besser so: Fehler machst du nicht, Fehler passieren. Du kannst sie passieren lassen, daraus lernen und besser werden! Am Ende wirst du dann besser gefunden. Und auch das, kann passieren.

Das könnte dich auch interessieren: